Antes decíamos “ver para creer”. Hoy necesitamos “ver para verificar”. Una foto o un video convincentes ya no son evidencias suficientes. Puede haber sido creados, alterados o amplificados por inteligencia artificial sin dejar huellas visibles. Y tampoco hay herramientas 100% infalibles para detección.

Entonces, ¿cómo verificar si un video fue creado o alterado con IA? La respuesta corta: no existe una herramienta 100% infalible, pero sí hay métodos de verificación que aplican las organizaciones firmantes de la International Fact-Checking Network, IFCN: analizar el archivo, mirar la imagen y el audio con lupa, reconstruir contexto y ser transparentes sobre límites y dudas en el proceso de verificación.

ANTES DE EMPEZAR, ¿QUÉ ES UN VIDEO GENERADO CON IA Y POR QUÉ ES INSUFICIENTE “VER PARA CREER”?

En la práctica, según el Poynter Institute, existen tres grandes familias de contenidos de este tipo:

– Deepfakes de rostro y voz: Modifican la cara o la voz de una persona real para que parezca que dijo o hizo algo que nunca ocurrió.

– Videos íntegramente sintéticos: Herramientas “texto a video” que crean escenas completas desde cero, mezclando elementos fotorealistas.

– Videos reales, pero manipulados o sacados de contexto: Recortes, ralentizados, doblados con audio falso, o reutilizados con otra narrativa, muy común en conflictos y campañas.

Así, reconocer un video generado con IA no es una prueba visual sencilla, sino que implica un proceso de verificación. Incluso periodistas especialistas en verificación y la Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura, Unesco, advierten que los deepfakes de última generación pueden ser prácticamente indistinguibles a simple vista y que la principal respuesta se encuentra en la denominada “alfabetización mediática e informacional”.

Así, el uno de octubre anterior, la Unesco advirtió que “a medida que las deepfakes difuminan la realidad, la educación debe ir más allá de la detección y enseñar a los estudiantes a navegar por la verdad, el conocimiento y la incertidumbre mediada por la IA”.

¿Cómo enfrentar este desafío?

Paso uno: antes de mirar píxeles, verifica el contexto y la fuente

Igual que el paso anterior, antes de entrar a la verificación técnica, conviene evaluar si el contenido merece atención mediante preguntas básicas:

– ¿Tiene alto alcance o potencial de viralización?

– ¿Puede causar daño real (incitación a la violencia, odio, desinformación electoral o sanitaria, etc.?

Este filtro ayuda a evitar dedicar recursos a cada video extraño que aparece.

Paso tres: conservar el archivo y revisar los datos básicos

Si es posible descargar el video y no solo verlo incrustado en redes o páginas web:

– Guarda el archivo original, o la versión más cercana posible al original.

– Revisa los datos básicos del archivo: da click derecho sobre la imagen y luego, Propiedades y Obtener información:

– Formato (.mp4, .mov, etc.)

– Duración

– Resolución (vertical tipo redes, horizontal, 4:3, etc.)

– Tamaño del archivo

En talleres y guías prácticas, organizaciones signatarias de la IFCN como Chequeado y Maldita.es utilizan este primer vistazo para mostrar que muchos videos virales ya han pasado por aplicaciones de edición o compresión antes de llegar a la audiencia.

Así, si no es “directo de cámara”, asumimos que es un producto mediado, es decir, editado, comprimido, reexportado. Eso exige un nivel mayor de sospecha.

Paso cuatro: revisar metadatos y huellas técnicas (cuando no se han perdido)

Cuando el archivo puede descargarse, es útil examinar sus metadatos y otras huellas técnicas. Herramientas gratuitas como MediaInfo o VLC permiten obtener esta información básica:

Fecha y hora de creación del archivo:

– ¿Es coherente con la fecha en que supuestamente se grabó?

Dispositivo o cámara utilizados:

– ¿Aparece un modelo concreto de teléfono o cámara?

– ¿Solo figuran etiquetas genéricas de software, como mp42, isom, “Adobe…”, “CapCut…” u otras referencias propias de programas de edición?

Software de edición:

– Si aparece mencionado, indica que el video fue procesado en algún momento y no proviene “crudo” del dispositivo que lo grabó.

Es cierto que muchos metadatos se pierden al subir contenido a redes sociales, debido a la compresión y reexportación de los archivos. Sin embargo, cuando sobreviven, pueden ser claves para reconstruir la historia del material. Esta revisión es una práctica estándar en cursos y formaciones de verificación de los medios signatarios de la IFCN.

Paso cinco: analizar la imagen y el audio

Guías recientes de Full Fact (“How to spot deepfake videos and AI audio”) y del Poynter Institute (“How to spot deepfake videos like a fact-checker”) coinciden en una recomendación central: no confiar en impresiones generales, sino buscar patrones recurrentes en la imagen y en el sonido que suelen aparecer en videos creados o alterados con IA.

Señales visuales a observar:

– Bordes del rostro o del cabello anómalos: brillo irreal, halos o fusión con el fondo.

– Piel excesivamente lisa: ausencia de microdetalles naturales.

– Parpadeos irregulares: demasiado escasos, perfectamente sincronizados o antinaturales.

– Boca y dientes extraños: desajuste con el audio, dientes mal definidos o con apariencia “gelatinosa” al pausar.

– Manos o dedos deformados: cambios sutiles de forma entre fotogramas.

– Textos y letreros del fondo inestables o deformados: dificultad para leerlos o falta de coherencia tipográfica.

– Sombras y luces inconsistentes con el entorno: direcciones incompatibles o reflejos imposibles.

Audios que con corresponden con el video:

– Voz demasiado limpia: ausencia de ruidos ambientales donde deberían existir.

– Entonación plana o robótica: falta de variación natural en el habla.

– Cortes de audio perfectos sin correspondencia visual: transiciones sonoras sin cambios en la imagen.

– Desfase sutil entre labios y voz: sincronización imperfecta.

Full Fact subraya que estas señales no permiten afirmar con certeza absoluta que un contenido fue generado con IA, pero sí activan la siguiente fase del proceso: la verificación del contexto y de las fuentes confiables

Paso seis: usar herramientas automáticas, pero conociendo sus limitaciones

Las herramientas automáticas ayudan a identificar señales tempranas de posible manipulación, pero la verificación final requiere una mirada crítica mediante la antesmencionada verificación visual, contexto y contraste de fuentes. tanto Poynter como Full Fact coinciden en una advertencia clave: estas herramientas no son lo suficientemente fiables como para sostener, por sí solas, una verificación concluyente.

Esto implica comprender cómo funcionan, qué limitaciones tienen y cómo interpretar sus resultados sin caer en tecnodeterminismos. El pensamiento crítico sigue siendo el núcleo del proceso: las máquinas orientan, pero no deciden.

Para imágenes:

– Hive – AI-Generated Content Detection: APIs para detectar contenido generado por IA en imagen, video, audio y texto.

– Illuminarty: Detector de imágenes (y textos) generados o alterados por IA, entrenado en modelos como Midjourney, DALL·E y Stable Diffusion.

– AI or Not: Plataforma multimodal que estima si imágenes, textos, música y video fueron generados por IA.

– Deepware Scanner (visual): Parte de la suite Deepware, centrada en detectar deepfakes de rostro principalmente en video, con componentes open source.

Para video:

– Deepware Scanner: Escaneo de videos para detectar deepfakes y manipulaciones faciales (web, API, CLI).

– Sensity AI: Plataforma enterprise de detección de deepfakes (video, imagen, audio, identidad) con informes y APIs.

– Hive (video): Modelos para estimar si un video fue generado/manipulado por IA, integrados en su stack de moderación.

– Amber Authenticate / Amber Detect: Herramientas para autenticar video desde el momento de grabación (hash + blockchain) y detectar alteraciones posteriores; pensadas para evidencia y cadena de custodia.

– Microsoft Video Authenticator: Tecnología de Microsoft anunciada en 2020 para estimar manipulación en imagen y video; actualmente no disponible como herramienta pública de uso general.

Un ejemplo…

En la práctica, la verificación visual, resulta muchísimo más importante que las herramientas de detección más conocidas y utilizadas.

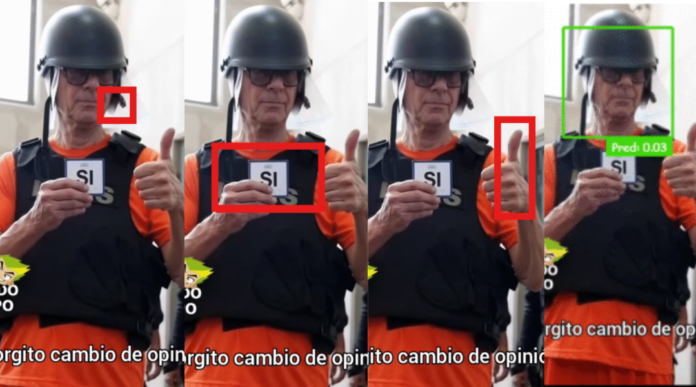

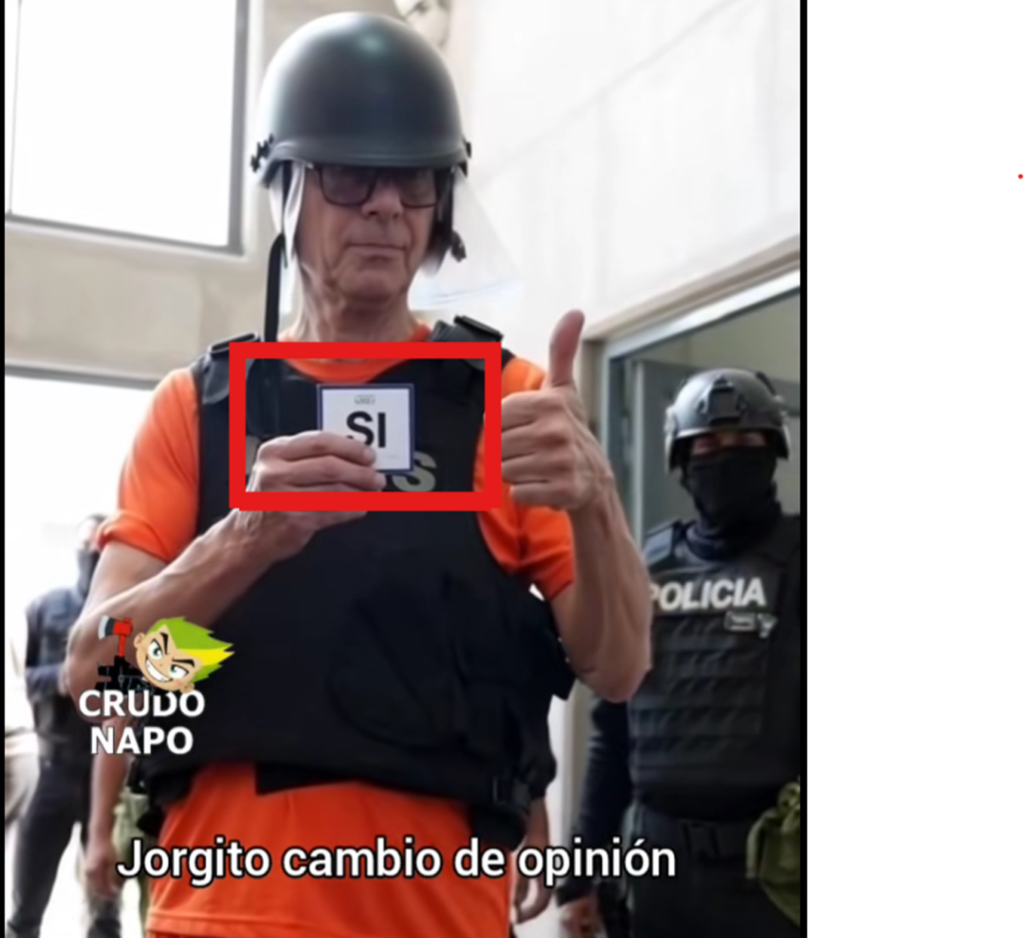

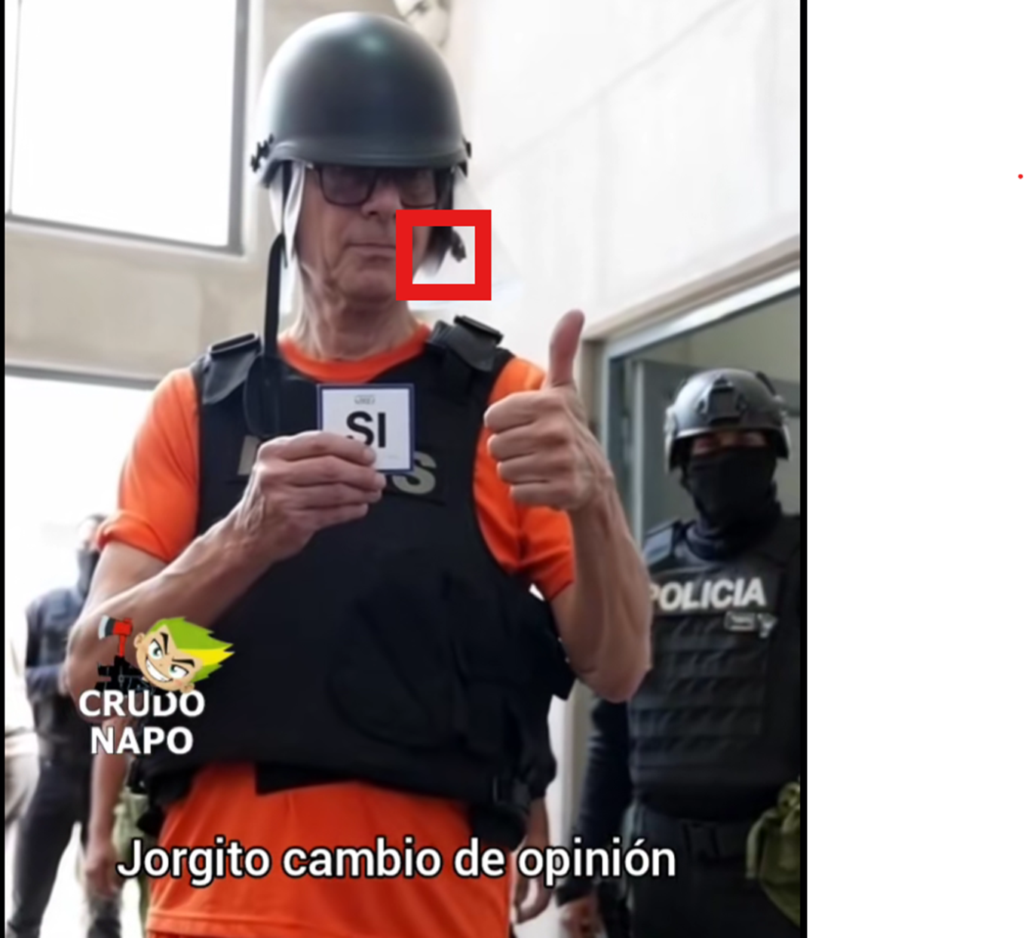

Así, días antes de la consulta popular del 16 de noviembre anterior, por ejemplo, se difundió un video alterado con inteligencia artificial del exvicepresidente, Jorge Glas, expresando gestos de apoyo al voto por el Sí al ingresar a la cárcel de El Encuentro, en la provincia de Santa Elena.

Esta pieza no pudo ser detectada por cuatro de las más populares herramientas de detección, que arrojaron los siguientes resultados:

| Herramienta de detección | Resultado | Nivel de confianza |

| Avatarify | No se ha detectado ningún deepfake | 2 % |

| Deepware | No se ha detectado ningún deepfake | 8 % |

| Seferbekov | No se ha detectado ningún deepfake | 26 % |

| Ensemble (promedio) | No se ha detectado ningún deepfake | 14 % |

Así, aplicamos las recomendaciones de inspección visual antes mencionadas y detectamos lo siguiente:

El cartel con la palabra “SÍ” presenta bordes excesivamente nítidos, un color blanco plano y una ausencia total de interacción lumínica con el entorno. No proyecta una sombra coherente sobre la mano ni refleja la iluminación ambiental. Este patrón corresponde a una superposición gráfica (overlay) añadida en posproducción, no a un objeto físico presente en la escena.

El gesto del pulgar arriba no aparece en las secuencias ni en las fotografías oficiales del evento original, que corresponde al traslado de Jorge Glas a la cárcel del Encuentro, en la provincia de Santa Elena. Además, el pulgar es desproporcionado, con un tamaño mayor que el de la mano y una posición anatómicamente improbable. También se observan bordes recortados y signos de pegado digital, indicativos de manipulación.

El caso antibalas deja ver parcialmente la pared blanca del fondo, es decir una transparencia físicamente imposible

Además, en la verificación de contexto constatamos que la cuenta desde donde se difundió este video, @crudo.napo, tiene un historial de contenidos satíricos y políticos. Sin embargo, esto no la exime de la responsabilidad de etiquetar de manera clara las piezas de parodia, especialmente en un caso como este, en el que existía riesgo de confusión en el marco de la consulta popular del 16 de noviembre. Así, aunque el traslado de Jorge Glas a la “Cárcel del Encuentro” fue un hecho verificado por fuentes oficiales y medios, el video que muestra al exvicepresidente sosteniendo un cartel con la palabra “SÍ” fue manipulado: la tarjeta y el subtítulo fueron añadidos digitalmente y no forman parte de los videos sobre el traslado publicados originalmente tanto por el presidente, Daniel Noboa como por medios confiables.